Hugging Face Inference Providers : تعتبر منصة Hugging Face أكبر قاعدة بيانات للنماذج مفتوحة المصدر (Open Source Models). ولكن دائماً ما يواجه المطورون والباحثون تحدياً كبيراً: كيف نشغل هذه النماذج بشكل عملي ورخيص؟ تشغيل النماذج محلياً يتطلب بطاقات رسوميات (GPUs) باهظة الثمن، واستخدام النماذج المغلقة مثل ChatGPT قد يكون مكلفاً في المشاريع الكبيرة. الحل يكمن في خدمةInference Providers التي تقدمها Hugging Face، والتي سنشرحها بالتفصيل في هذا المقال.

1. ما هي خدمة Hugging Face Inference Providers؟

يمكن اعتبار هذه Hugging Face Inference Providers بمثابة “موجه” (Router) للنماذج مفتوحة المصدر. بدلاً من تشغيل النموذج على جهازك، تقوم شركات متخصصة باستضافته على خوادمها القوية، وتتيح لك Hugging Face الوصول إليها جميعاً من مكان واحد.

بدلاً من الاشتراك مع كل مزود خدمة بشكل منفصل (مثل Replicate أو Fal AI أو Groq)، يمكنك استخدام حسابك في Hugging Face للوصول إليهم جميعاً باستخدام اشتراك واحد ومفتاح API واحد.

أهم المزودين (Providers) المتاحين:

- Cohere

- Fal AI

- Replicate

- Fireworks

- Groq

- Nebius

2. ماذا يمكنك أن تفعل بهذه الخدمة؟

تغطي الخدمة معظم مهام الذكاء الاصطناعي الأساسية :

- المحادثة (Chat Completion): مثل بناء بدائل لـ ChatGPT.

- توليد الصور (Text to Image): تخليق الصور من النصوص.

- توليد الفيديو (Text to Video): إنشاء مقاطع فيديو من نصوص.

- استخراج الخصائص (Embeddings): تحويل النصوص إلى أرقام لاستخدامها في البحث الدلالي وتقنيات RAG.

3. خطوات العمل: كيف تختار النموذج وتستخدمه؟

الخطوة الأولى: اختيار النموذج المناسب

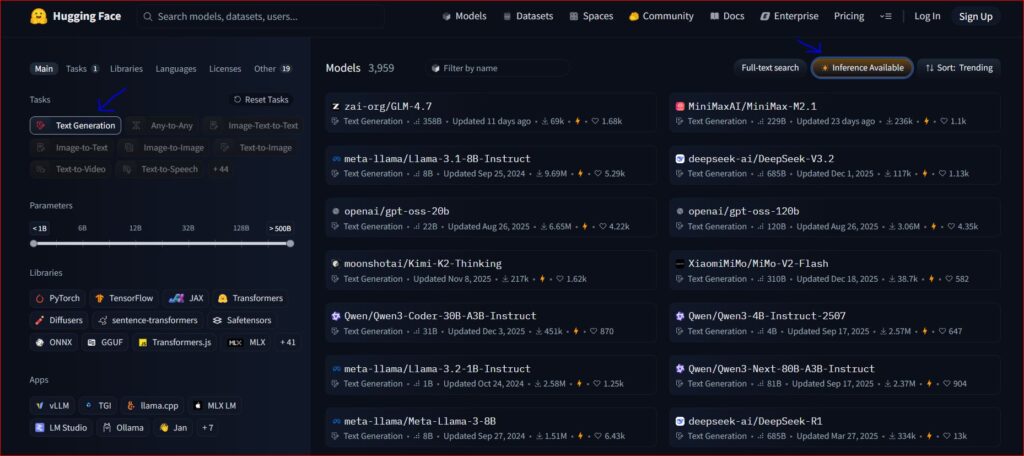

- اذهب إلى صفحة Models في Hugging Face.

- اختر المهمة (مثلاً Text Generation).

- نقطة مهمة: اضغط على زر “Inference Providers” أو “Inference Available” لفلترة النماذج التي تدعم هذه الخدمة (سيقلص العدد من مئات الآلاف إلى بضعة آلاف جاهزة للاستخدام الفوري) [03:50].

الخطوة الثانية: الحصول على الكود

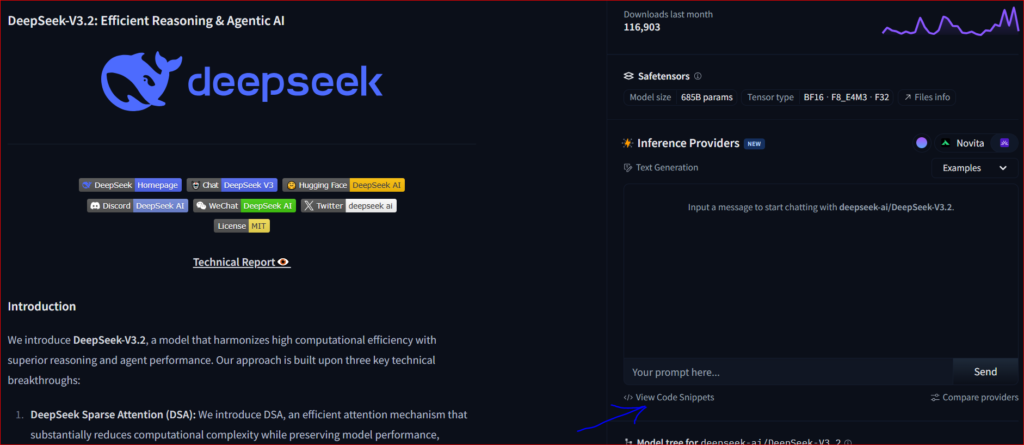

عند الدخول لصفحة أي نموذج (مثل MiniMax أو Qwen أو DeepSeek )، ستجد زر Inference Providers.

عند الضغط عليه، سيظهر لك كود جاهز (Python أو JavaScript). يمكنك اختيار مزود خدمة محدد (مثل Novita) أو ترك الخيار على “Auto” ليختار Hugging Face الأفضل تلقائياً .

الخطوة الثالثة: إعداد مفتاح الوصول (API Token)

للعمل برمجياً، تحتاج إلى مفتاح خاص:

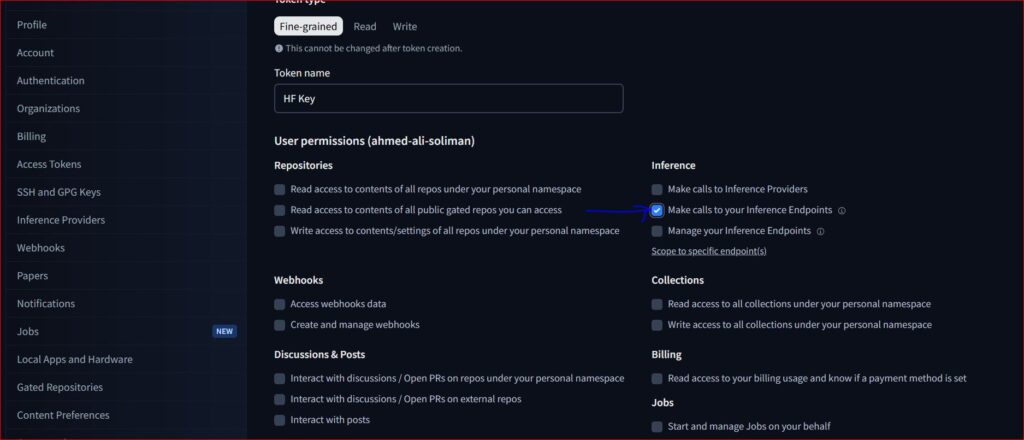

- اذهب إلى إعدادات حسابك في Hugging Face -> Access Tokens.

- أنشئ مفتاحاً جديداً (Create New Token).

- هام جداً: تأكد من تفعيل صلاحية “Make calls to inference providers” .

4. التكلفة والتسعير (Pricing)

هذه هي الميزة الأقوى في الخدمة. Hugging Face لا تأخذ عمولة إضافية.

- أنت تدفع فقط السعر الذي يحدده مزود الخدمة (Provider).

- إذا كان توليد الصورة يكلف 1 سنت عند المزود الأصلي، ستدفع 1 سنت عبر Hugging Face.

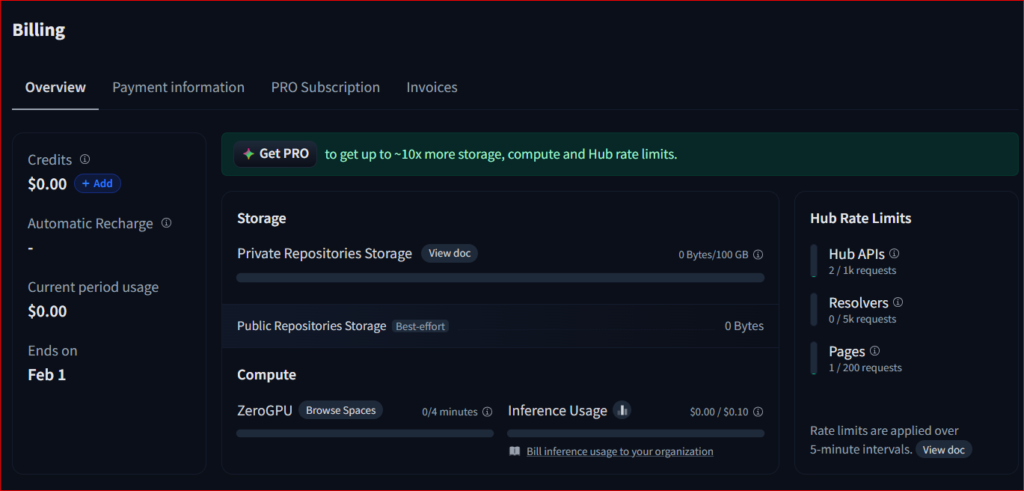

- الحسابات المجانية: تحصل على رصيد تجريبي (حوالي 10 سنت شهرياً).

- حسابات Pro: تحصل على رصيد شهري بقيمة 2 دولار، وهو مبلغ كافٍ جداً لتوليد مئات الصور أو إجراء العديد من المحادثات النصية، حيث أن تكلفة هذه العمليات منخفضة جداً .

يمكنك متابعة استهلاكك ومصاريفك بدقة عبر لوحة تحكم Inference Usage في حسابك، والتي تظهر لك تكلفة كل عملية قمت بها .

الخاتمة

تعتبر Hugging Face Inference Providers خياراً مثالياً لمن يبحث عن حلول عملية، فعالة، ورخيصة لدمج الذكاء الاصطناعي في مشاريعه دون الحاجة لدفع اشتراكات باهظة أو شراء عتاد قوي. إنها جسر الوصول الأسهل لعالم النماذج مفتوحة المصدر.